光学基础知识大讲堂

——第5期:什么是超分辨?

http://www.opticsjournal.net/M/gxxb/News/PT160829000442NjPmS.cshtml

日常生活中,我们看的超清电视,电脑屏幕,照相机拍的照片,都有像素一说,比如1024×1024,像素越高,表示图像质量越接近于原始图像。如果把低像素的图片放大到一定程度,图片会非常模糊,类似于马赛克的情况。

图1 像素较低的图片

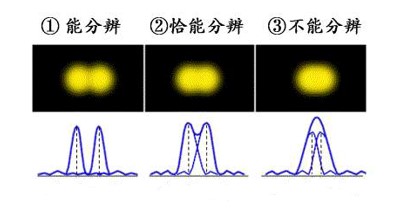

上面说的图像都是经过机器或者系统得到的图片,那么问题来了,如果直接用人眼观察某一个物体,会出现上面类似马赛克的情况吗?答案是也会,虽然非常非常小(纳米量级),这就是我们常说的衍射极限。所谓衍射极限就是,由于光的衍射特性,一个物点发出的光会形成一个弥散斑(也称艾里斑),当二个物点靠近的时候,达到一定程度就不能再区分开来,通常我们把200 nm称为分辨率极限。

图2 衍射极限(图片来源于网络)

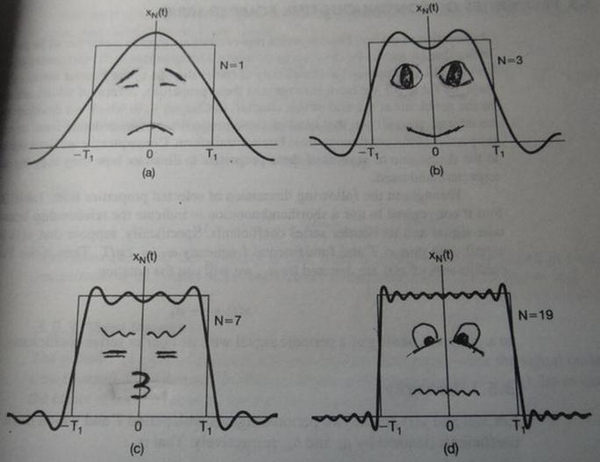

那么衍射极限的大小(即分辨率的大小)又是由谁决定的呢?现在我们来看看衍射极限的公式(本来我是极不情愿在科普文章里面写公式的,霍金曾说过,加一个公式就会少一半的读者,好吧,为了看清两者之间的关系,最后还是决定加上):

(1)

(1)

式中δ表示显微镜可分别的最小刻度,λ表示光的波长,NA表示显微镜的数值孔径,一般不会超过2。显而易见,分辨率的大小与波长λ成正比,波长越小,说明能看清的最小刻度越小。比如,蓝光的波长比红光要小,所以相对应蓝光的最小分辨率要优于红光。可以想到,既然波长决定了分辨率的极限,那用更小的波长不就好了,比如紫外光、X射线甚至γ射线(电磁波波长分布见第3讲:详解电磁辐射),这回答没有毛病,但是波长越短能量越强,会对被观察的物体产生损伤,尤其是活细胞,这自然是我们不愿意看到的。那么问题又来了,有没有波长又很短,但是能量却不强,不会对观测目标造成伤害的?回答是:还真有,电子显微镜。电子显微镜采用的是电子束,而不是可见光,一般可见光波长范围在300~750 nm,但是电子束的波长当加速电压为50~100 kV时,可以达到0.0053~0.0037 nm。所以,电子显微镜的分辨率可达到0.1~0.2 nm,远优于可见光的200 nm。别高兴得太早,凡是有利必有弊,电子显微镜的样本必须在真空环境中才能够被观察,so活细胞之类的都不行,应用局限性太大。

看到这里,各位看官不要着急,我们肯定有办法能够超过衍射极限的。当然,之前的讨论也不是没有用处的,至少让我们明确一点,衍射极限并不是目标物体天然存在着分辨率极限,而是我们还没有这个水平看得更细、更清楚。那么在介绍超分辨技术之前,先来一探为什么我们不能看得更细的物理本质吧!

------------------------------------------------华丽的分割线,前方高能,请注意---------------------------------------------

物理本质

前面提到,由于光的物理特性(衍射特性)的存在,导致点光源形成艾里斑,重叠以后就难以分辨。这一衍射特性本质上来源于量子光学里的不确定性原理(即海森堡的测不准原理)。不确定性原理表示,你不可能同时知道粒子的位置和速度(动量),动量不确定性越小,位置不确定度越大,反之亦然。换句话说,当一个光子在某个方向的动量范围确定的情况下,其分辨率也就确定下来了。根据光子动量的公式p=h/λ,波长λ越小,动量不确定度Δp越大,那就意味着位置不确定度越小,分辨率就越高,其实与公式(1)相吻合。

然后我们再从傅里叶理论的角度来分析解释下:学摄影或者图像处理的都知道,携带物体信息的光波,高频部分代表细节,低频部分代表轮廓。那如果我们分辨不出图像的细节,只能说明物体高频部分的信息丢失了。为什么呢?由于光有很宽的频谱范围,而光频率的较高部分,当满足一定的相位匹配条件,会形成倏逝波,而倏逝波的特点是光的幅值在垂直深度方向指数衰减,这意味着物体含有高频部分的光走了波长量级的路程后就衰减没了,只有低频部分的光到达成像面,因此导致信息(细节部分)的丢失。

而关于上面加黑的那句话“高频部分代表细节,低频部分代表轮廓”有人可能不太理解,那么我们再引入点扩展函数和傅里叶理论融会贯通。

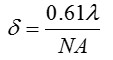

点扩展函数是以空间频率为变量传递的像的调制度和相移的函数。顾名思义,点扩展函数从频域上来说是以频率为变量,而时域上是如图2的脉冲图像。接下来,我们再来看看傅里叶级数的变化吧。

如图3所示,(a)图是N=1,表示频率ω的正弦函数,(b)图表示频率ω和频率3ω的叠加,(c)表示频率ω、频率3ω、频率5ω、频率7ω的叠加,(d)表示10个不同频率的叠加。显然,当高频率叠加得越多,叠加后的时域图形越接近于矩形(其实脉冲上升沿的斜率就代表着细节高频成分的多少)。想象一下,如果如图2的点光源,时域脉冲是一个矩形的样子,而不是一个高斯线型,那么分辨率还会因为艾里斑叠加而看不清吗?当然,这只是一个非常理想的愿望,永远也不可能实现,例如现在的激光器追求的光束质量品质因子就是这样,要求尽量小的光束发散角,但永远也不可能不发散。

图3 傅里叶级数(图片来源于知乎,作者 Heinrich)

--------------------------------------------------------华丽的分割线----------------------------------------------------

超分辨技术

前面提到由于倏逝波的原因,高频部分的光只能传播波长量级的距离就衰减了,导致细节部分丢失,分辨率最高一般只能在200 nm左右。那如果要实现超分辨的第一个办法就是:乘它还没衰减之前就成像。这就是传说中的近场成像,近场成像自然不受传统的衍射极限的限制,分辨率能够高达纳米量级,但是在应用上存在同样的问题,如此贴近距离的测量,一则肯定不利于活细胞的观测,二则视场被限制得很厉害,存在畸变失真。

那么相对于近场成像,另外一个就显而易见了,远场成像。通常,我们所说的光学显微镜的超分辨成像技术指的就是远场成像,2014年诺贝尔化学奖授予了美国及德国三位科学家Eric Betzig、Stefan W. Hell和William E. Moerner,以表彰他们在远场超分辨成像技术领域取得的成绩。

远场超分辨成像技术可以分为两类:一类是基于单分子定位技术的超分辨显微成像方法,包括光激活定位显微技术(PALM)和随机光学重构显微技术(STORM);另一类是基于点扩展函数调制的超分辨显微成像方法,包括受激发射损耗显微技术(STED)和结构照明显微技术(SIM)。植入广告:期刊《光学学报》于2017年3月份出版一期“超分辨成像”专题,如有兴趣的童鞋敬请关注。

第一类,基于单分子定位的超分辨技术,其基本原理是:通过技术手段标记细胞的蛋白质,然后利用激光器低能量照射细胞表面,激活稀疏分布的几个荧光分子进行定位,再重复上百次,然后拟合这些图像到一张图上,从而得到分辨率提到10倍以上的定位精度。这类技术从本质上来说并没有缩小点扩展函数,而是通过牺牲时间分辨率,从而来提高空间分辨率。图4是随机光学重构显微技术(STORM)的发明者美国霍华德-休斯顿研究所华裔科学家庄晓薇。

图4 美国华裔科学家庄晓薇(图片来源于网络)

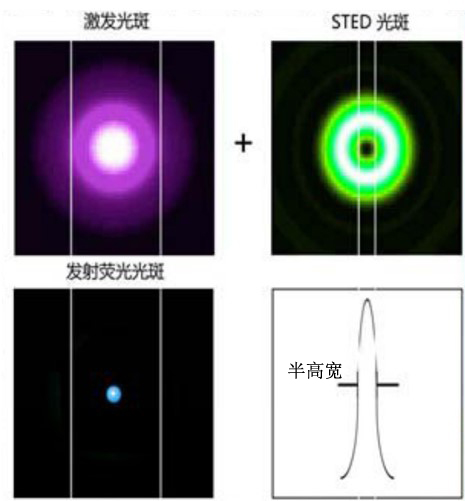

第二类,基于点扩展函数调制的超分辨技术。这一类是真正从源头上提高了图像的分辨率。例如,2014年诺贝尔化学奖的受激发射损耗显微技术(STED)原理如下:通过添加一路激光(图5(a)),让这路激光和原先的激光艾里斑叠加(图5(b)),但是新添加的激光光斑会有效抑制艾里斑边沿区域的激发态荧光分子发光(图5(c)),从而大大减小了光源的点扩展函数的半高宽,分辨率极限可以达到16 nm。

图5 STED原理图(图片来源于网络)

超分辨技术,尤其是远场超分辨成像技术越来越多地应用在生活当中,在生物医学方面,除了静态样品的观测外,活体细胞等样品的观测也越来越成熟,其他例如精细微结构的光刻、微纳加工等领域也都有着重要的应用。相信随着超分辨成像技术的进一步发展,我们的世界会更加精细。